Odważne działania w zakresie AI oznaczają odpowiedzialność

W Google wierzymy, że nasze podejście do AI musi być zarówno odważne, jak i odpowiedzialne. Oznacza to, że chcemy rozwijać AI z korzyścią dla społeczeństwa, jednocześnie rozwiązując problemy. Kierujemy się przy tym naszymi zasadami dotyczącymi AI. Wprawdzie wydaje się, że te dwa podejścia wykluczają się nawzajem, jednak wierzymy, że ich produktywne połączenie jest możliwe, a tak naprawdę niezbędne. Jedynym sposobem na odważne postępowanie na dłuższą metę jest bycie odpowiedzialnym od samego początku. Odważnie używamy AI w naszych przełomowych usługach i badaniach naukowych, a także aby pomagać w rozwiązywaniu problemów wynikających z wyzwań społecznych.

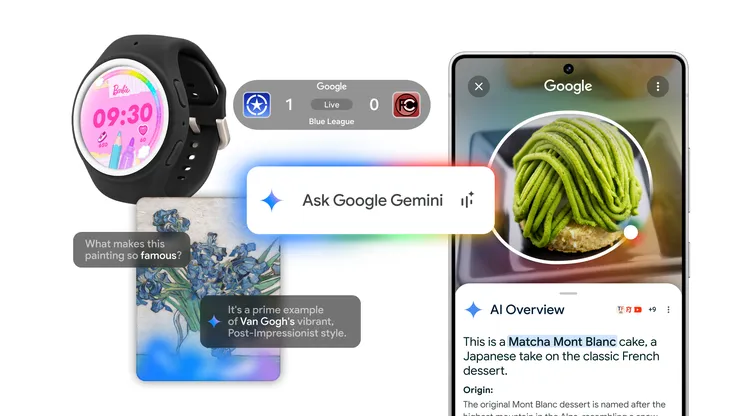

W przypadku naszych produktów – AI może pomóc w rozbudzaniu kreatywności z wykorzystaniem Barda, zwiększyć wydajność podczas korzystania z narzędzi Google Workspace i zrewolucjonizować dostęp do wiedzy dzięki generatywnemu wyszukiwaniu.

W odniesieniu do wyzwań społecznych – stosujemy AI, aby łagodzić skutki zmian klimatycznych i szukać sposobów na radzenie sobie z nimi. Zapewniamy prognozy powodziowe, śledzimy w czasie rzeczywistym granice pożarów lasów i pomagamy w redukowaniu emisji dwutlenku węgla poprzez zmniejszanie korków na drogach. Ponadto korzystamy z AI, aby ulepszać ochronę zdrowia, m.in w zakresie opieki zdrowotnej dla matek, leczenia nowotworów i badań przesiewowych w kierunku gruźlicy. Niedawno zapowiedzieliśmy też wprowadzenie nowego modelu językowego Med-PaLM, który może być pomocnym narzędziem dla lekarzy. Jeszcze w tym roku udostępnimy Data Commons – system porządkowania danych pochodzących z setek różnych źródeł, który będzie dostępny za pośrednictwem Barda i zwiększy jego skuteczność.

W obrębie naszych pionierskich badań – AI pomaga naukowcom w dokonywaniu śmiałych postępów, jak w przypadku programu AlphaFold od Google DeepMind. AlphaFold może dokładnie przewidywać modele 3D 200 milionów białek, czyli prawie wszystkich, jakie dotąd zna nauka. W kilka tygodni osiągnęliśmy w ten sposób postęp, który mógłby wymagać 400 milionów lat badań. AI umożliwia również podejmowanie śmiałych wyzwań, jak w przypadku naszego projektu inkluzywności językowej — poczyniliśmy ogromne postępy w realizacji naszego celu, jakim jest obsługa 1000 najczęściej używanych języków za pomocą uniwersalnego modelu mowy przeszkolonego w ponad 400 językach.

Wprawdzie takie odważne przełomy są bardzo emocjonujące, jesteśmy jednak świadomi, że technologia AI jest wciąż w fazie rozwoju i być może jej wpływ na obecne wyzwania społeczne będzie negatywny. Może też się zdarzyć, że wraz z jej rozwojem i wykorzystywaniem w różnych dziedzinach będą się pojawiały zupełnie nowe wyzwania. Dlatego wierzymy, że niezbędne jest odpowiedzialne podejście do AI, które stosujemy w oparciu o nasze zasady dotyczące AI ustalone w 2018 roku.

Obszarem, który budzi obawy wielu osób, jest szerzenie nieprawdziwych informacji. Dzięki generatywnej AI tworzenie nowych treści jest teraz łatwiejsze niż kiedykolwiek, jednak pojawiają się obawy o ich wiarygodność. Dlatego nieustannie staramy się rozwijać i dostarczać użytkownikom narzędzia umożliwiające ocenę informacji dostępnych w sieci. W najbliższych miesiącach wzbogacimy wyszukiwarkę Google o nowe narzędzie umożliwiające poznanie szerszego kontekstu – „Informacje o tym obrazie”. Dzięki tej funkcji będzie się można na przykład dowiedzieć, kiedy i gdzie prawdopodobnie pierwszy raz pojawiły się podobne obrazy. Można będzie również uzyskać informacje na temat innych miejsc, w których dany obraz jest dostępny online, takich jak strony z wiadomościami, media społecznościowe czy strony służące do weryfikowania informacji. Narzędzie „Informacje o tym obrazie” będzie dostępne jeszcze w tym roku w Chrome i Obiektywie Google.

Stosując się do zasad dotyczących AI w naszych usługach, zauważamy potencjalne problemy, jeśli chodzi o odwagę i odpowiedzialność. Przykładem może być Universal Translator – eksperymentalny serwis oparty na AI, służący do tworzenia dubbingu do filmów. Jest on pomocny dla ekspertów tłumaczących wypowiadany w filmie tekst, którzy muszą ponadto dopasować go do ruchów warg. Narzędzie to ma ogromny potencjał w zakresie zwiększania rozumienia, jednak wiemy, że w niewłaściwych rękach może stanowić ryzyko. Dlatego w usłudze tej wprowadziliśmy zabezpieczenia, które mają ograniczać niewłaściwe wykorzystywanie, jednocześnie dając do niej dostęp jedynie autoryzowanym partnerom.

Innym sposobem na stosowanie naszych zasad dotyczących AI jest tworzenie innowacji, które mają być pomocne w radzeniu sobie z pojawiającymi się wyzwaniami. Wiele firm, w tym również Google, zatrudnia ekspertów do spraw bezpieczeństwa, aby przeprowadzali tzw. testy adwersarialne, czyli wykrywali złe rezultaty, które generowane są przez wzorce takie jak niesprawiedliwe uprzedzenia. Jesteśmy jedną z pierwszych firm w branży, jeśli chodzi o automatyzację testów adwersarialnych przy użyciu modelu językowego LLM, który znacząco poprawia prędkość, jakość i zakres testów. Dzięki temu eksperci zajmujący się bezpieczeństwem mają więcej czasu, aby skupić się na trudniejszych zagadnieniach. W ramach walki z szerzeniem nieprawdziwych informacji będziemy wkrótce integrować z naszymi najnowszymi modelami generatywnymi kolejne innowacje w zakresie analizy pochodzenia danych. Robimy również postępy w opracowywaniu narzędzi do wykrywania mowy syntetycznej – w opracowanym przez nas modelu AudioLM wytrenowaliśmy klasyfikator, który może wykrywać mowę syntetyczną w naszych modelach audio z blisko 99-procentową dokładnością.

Wiemy, że odpowiedzialne tworzenie modeli AI musi opierać się na wspólnym wysiłku, angażującym badaczy, specjalistów w zakresie nauk społecznych, ekspertów w branży, instytucje rządowe, twórców, wydawców oraz użytkowników korzystających z AI na co dzień.

Co roku publikujemy raporty o postępach, w których opisujemy, w jaki sposób wprowadzamy w życie nasze zasady dotyczące AI. Zawieramy też przykłady, jak opisane tu problemy i innowacje, tak aby można było się z nich uczyć.

Naszymi innowacjami dzielimy się z innymi, aby wywierać jeszcze większy pozytywny wpływ, tak jak było to w przypadku interfejsu Perspective API. Narzędzie to zostało pierwotnie opracowane przez naszych badaczy z Jigsaw w celu zmniejszenia liczby toksycznych komentarzy pojawiających się w sieci. Obecnie stosujemy je w naszych dużych modelach językowych (LLM), w tym w każdym z modeli wymienionych podczas konferencji I/O, a badacze akademiccy wykorzystali je do stworzenia branżowego standardu oceny wykorzystywanego przez wszystkie znaczące modele LLM, w tym OpenAI i Anthropic.

AI i kreatywność idą w parze, dlatego współpracujemy z artystami przy projektach takich jak MusicLM, dzięki któremu wystarczy opisać swój pomysł na muzykę, aby po chwili usłyszeć, jak brzmi. We współpracy ze społecznością internetową natomiast publikujemy nasze zasady, co ma stanowić pierwszy krok do utworzenia standardów odpowiadających za zachowanie zdrowego ekosystemu treści. Chcemy, aby wydawcy internetowi mieli wybór i kontrolę, jeśli chodzi o ich treści dostępne online, i mamy nadzieję, że w najbliższych miesiącach będziemy mogli podzielić się nowymi informacjami na ten temat.

AI jest tak ekscytują dziedziną między innymi dlatego, że nie jest technologią statyczną. Zmienia się i rozwija wraz ze wzrostem liczby osób, które chcą z niej korzystać, dzielić się nią i ją rozwijać. Nieustannie uczymy się z naszych badań i doświadczeń, a także od użytkowników i szerszej społeczności, i uwzględniamy zdobytą wiedzę w naszym podejściu. A co dalej? Jeszcze wiele możemy osiągnąć i wiele musimy odpowiednio uporządkować – działając razem.

Pragnę podziękować moim współpracownikom z zespołów Responsible AI, Responsible Innovation oraz Google.org i wyrazić uznanie dla ich niesamowitej pracy.